评估是改进应用程序的关键技术——无论是处理单个提示还是复杂代理。在比较模型、更新逻辑或迭代架构时,评估是为输出评分和了解更改影响的可靠方法。

但是,我们经常从团队那里听到的一个巨大挑战是:“我们的评估分数与我们期望的团队成员的说法不符。” 这种不匹配会导致比较结果嘈杂,浪费时间追逐虚假信号。

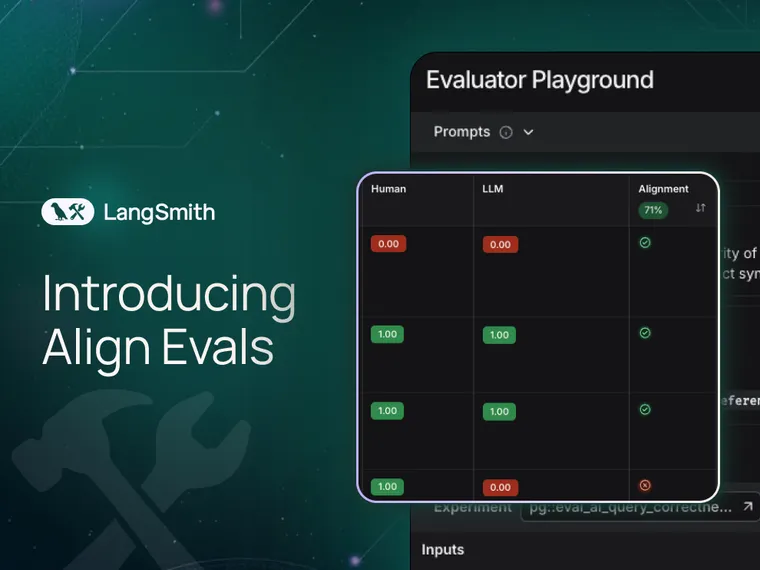

因此,我们推出了 **Align Evals**,这是 LangSmith 的一项新功能,可帮助您校准评估器,以更好地匹配人类偏好。此功能受到 Eugene Yan 关于构建 LLM 作为裁判的评估器的文章的启发。

该功能**今日起**对所有 LangSmith Cloud 用户可用,并将于本周晚些时候发布给 LangSmith Self-Hosted 用户。观看我们的视频演示或阅读我们的开发者文档以开始使用。

创建高质量的 LLM 作为裁判的评估器变得更加容易

到目前为止,迭代评估器通常涉及大量的猜测。很难发现评估器行为的趋势或不一致之处,在更改评估器提示后,很难清楚哪些数据点导致分数发生变化或为什么发生变化。

通过此新的 LLM 作为裁判的对齐功能,您将获得

- 一个类似游乐场界面的工具,用于迭代您的评估器提示并查看评估器的“对齐分数”

- 并排比较人类评分数据和 LLM 生成的分数,并通过排序来识别“未对齐”的案例

- 一个已保存的基线对齐分数,以便将您最新的更改与提示的先前版本进行比较

工作原理

对齐流程的工作原理如下

1. 选择评估标准

第一步是确定正确的评估标准。您的评估标准应包括您的应用程序应该擅长的事项。例如,如果您正在构建一个聊天应用程序,准确性很重要——简洁性也很重要。一个技术上准确但需要数段才能讲清楚的答案仍然会使用户感到沮丧。

2. 选择需要人工审查的数据

从您的应用程序中创建一组代表性示例。这些应涵盖好坏示例——目标是涵盖您的应用程序实际会生成的输出范围。例如,如果您正在为一个客户支持助手添加新产品,使其能够回答问题,请包含正确和不正确的响应。

3. 使用预期分数对数据进行评分

对于每个评估标准,手动为每个示例分配一个分数。这些分数将成为您的“黄金数据集”,它将作为评估器的响应将根据其进行判断的基准。

4. 创建评估器提示并针对人工评分进行测试

为您的 LLM 评估器创建初始提示,并使用对齐结果进行迭代。对于您提示的每个版本,您将针对人工评分的示例进行测试,以查看您的 LLM 分数与您的分数对齐的程度。

例如,如果您的 LLM 一直对某些响应评分过高,请尝试添加更清晰的负面标准。提高评估器分数是一个迭代过程。在我们的文档中了解有关迭代提示的最佳实践。

下一步是什么?

我们才刚刚开始。这是帮助您构建更好的评估器的第一步。展望未来,您可以期待

- **分析**,以便您可以跟踪评估器的性能随时间的变化。

- **自动提示优化**,我们将自动为您生成提示变体!

试试吧!通过访问我们的开发者文档或观看我们的视频教程开始。在LangChain 社区论坛中提供反馈,让我们知道您的想法。